人们都在慢慢使用AI了, 我也接受了这个事实. 在Chatgpt问世后, 一个奇技淫巧的黑洞被打开, 我认识的很多身边人, 甚至都开始用AI来编写稿件, 写年终总结等等. 不过, AI进行的音乐创作, 目前还是不太入流. 它们能抓住大体情绪, 能编写Rap歌词, 但旋律很难记住, 抓不住人, 某些编配结构上也几乎是从一而终, 显得敷衍. 当然这也和AI与人类的创作区别有关. 人类的音乐作品, 可能是由一个人完成, 也可能是由一群人完成, AI想不到这些, 它无法知道除了歌手以外, 贝斯手在想什么, 鼓手在想什么, 键盘手为什么会在下一小节来一段Solo等等.

但抛开AI当前的不足, 有些领域AI却真的能堪当重任. 比如AI人声.

AI人声其实并不复杂, 很多自媒体现在创作视频, 旁白都开始使用AI人声, 那些美猴王啊郭德纲的声音, 都来自AI. 这其实不是AI应用中水平较高的领域, 简单来说就是套模型, 就好比3D建模中, 你做好一个3D骨骼, 然后给它套上不同的皮肤一样, AI所做的就是分析你的骨骼, 把每一个节点都和皮肤上的节点对齐, 就完工了. 更好的AI还有自行建模功能, 你可以载入不同的声音, 让AI分析出有效的节点, 然后生成新的人声模型等等.

大概一年前我就开始了解这些. 当时听说了一个正在开发中的人声AI应用, 叫Replay, 我还进行了测试. 因此对AI制作人声的整个过程和其有效的应用面有了大体的判断. 但这些还是后话.

没多久, 我就发现SoundID也推出了一款VoiceAI的应用.

我对SoundID实在是再了解不过了. 它的后台品牌是Sonarworks, 它也是当前世界使用量第一的桌面监听矫正系统, 我也在使用他家的产品. 因此, 当VoiceAI推出后, 我立马进行了关注.

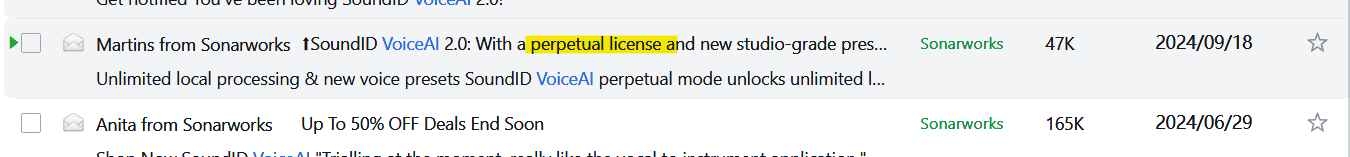

我进行了邮件搜索, 以追溯VoiceAI的准确推出日期. 2024年的4月9日.

但当我发现VoiceAI是使用Token计费制, 并需要订阅后, 我对这个产品的兴趣大打折扣. 我们都知道, 就是因为订阅制这种玩意, 让我们一度闹得Waves差点垮台, AVID销量锐减, 甚至如果PreSonus的StudioOne今年没有积极更新的举措, 我都会放弃这个陪伴了我十年的产品.

话说回来. 由于VoiceAI的订阅举措, 我对它根本提不起兴趣, 我也不太在意它所标榜的AI人声, 因为我大致对这方面有些了解.

但显然, SoundID也很快意识到了这一点, 仅仅不到半年, 他们就为VoiceAI加入了Perpetual买断制, 99美元买断. 这个价格相比之前订阅制的都便宜了很多, SoundID肯定意识到一开始的狮子大张口把诚意用户都给吓跑了.

可惜的是, AI系列的产品迭代速度太快, 如果你在刚推出时没有抓住核心用户, 不论你再做出什么补救, 这些用户都不会再留意你的名字. 听起来很残酷, 但要记住, 第一步坏招是你先走的.

到了2024年11月30日, SoundID又推出打折活动, 从99美元折到79美元. 但我还是跳过了这条邮件, 直到2025年1月1日, 我看到了一条油管视频, up主使用VoiceAI玩得不亦乐乎的场景, 让我打算试试它, 看看它与我了解的AI人声有什么过人之处.

我从官网上下载了VoiceAI, 他们说我有7天的试用期, 而且有9000个token的点数(他们没告诉你的是AI生成一次, 哪怕只是一句话, 就要用去800个token) .

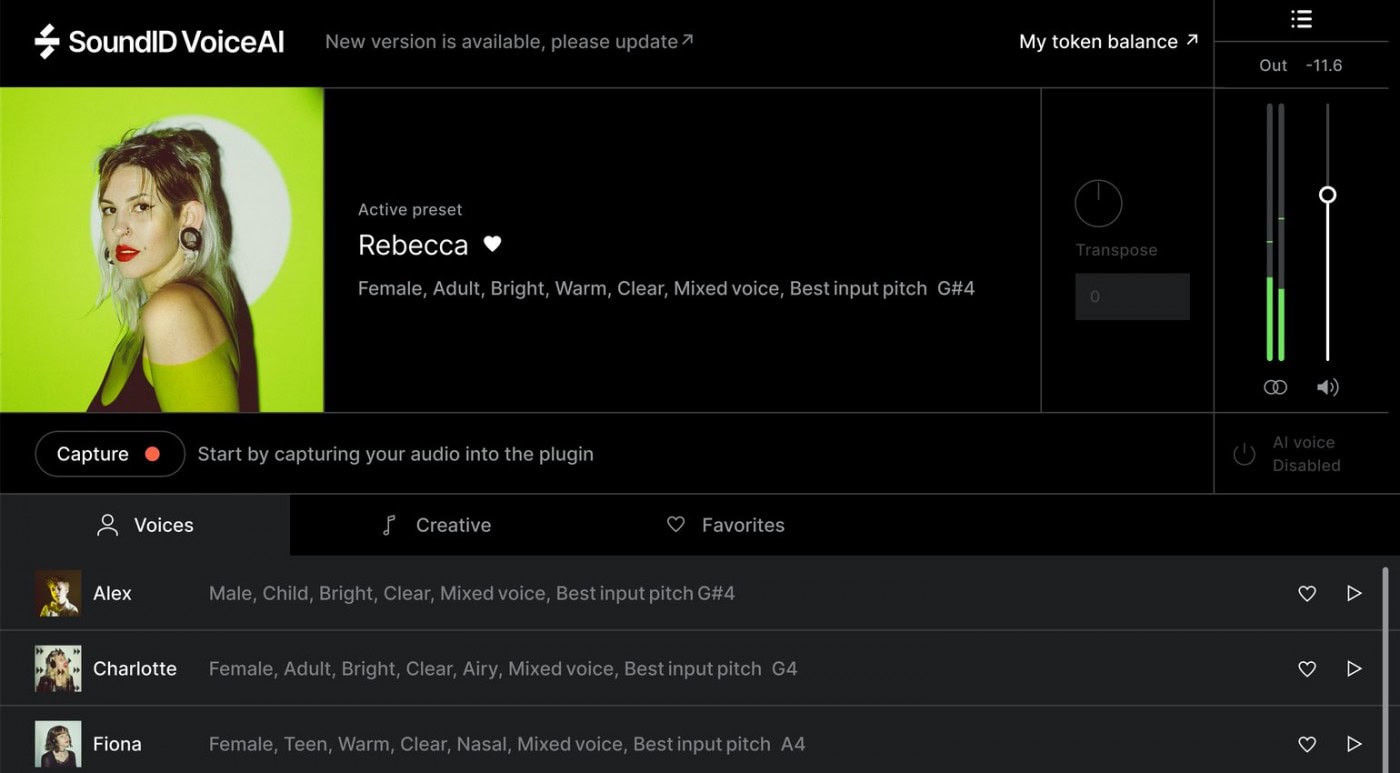

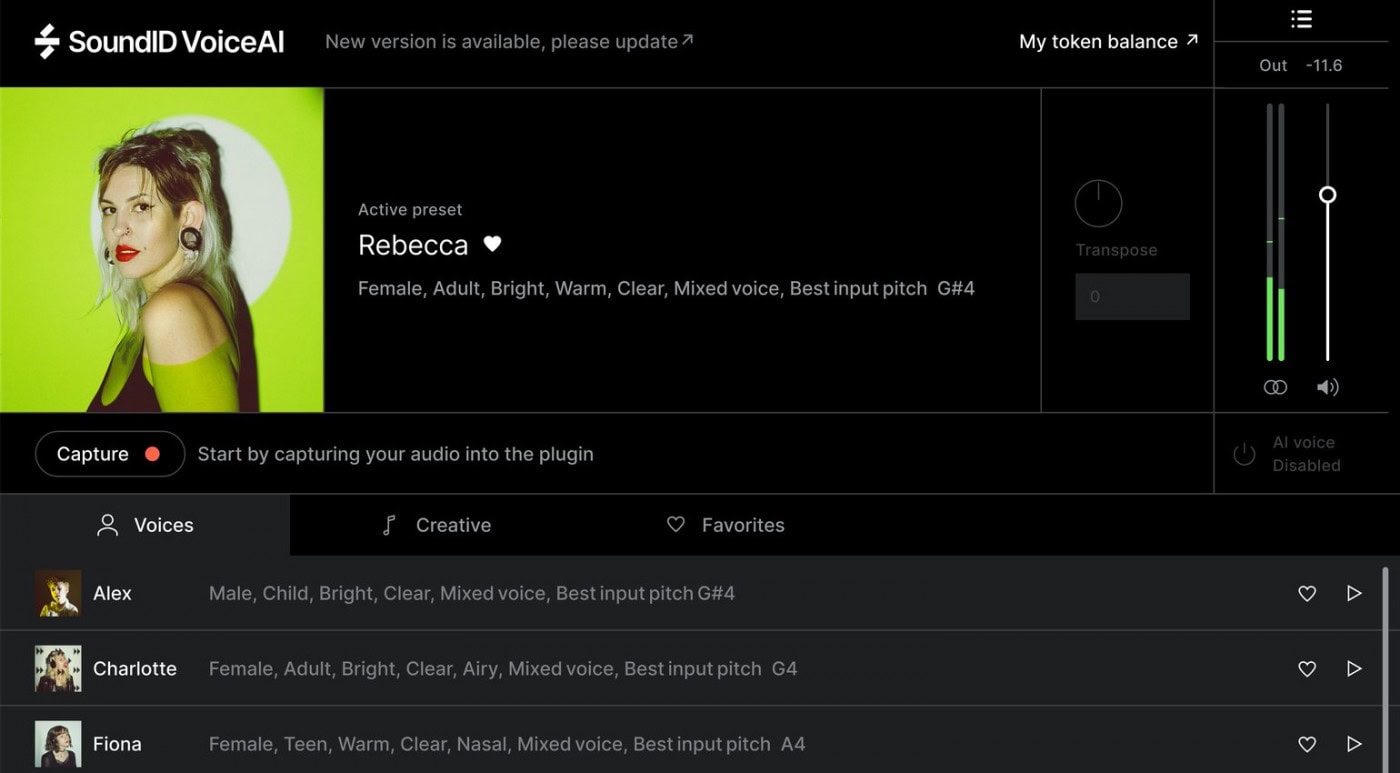

VoiceAI拥有插件版本, 这是值得肯定的. 在DAW中工作时, 遇到需要处理的声音, 直接拽入插件, 开始现场工作会非常方便. 整个插件的界面分布也直观美观. 对此我没有任何意见.

然而, 就在我费尽心思录制了一条人声音轨, 将以此作为参考, 从而进行人声替换时, 一切刚开始都很顺利, 转换进度条在走, 我也在期待着将要呈现的结果. 可但是但可是, 进度条停在了79%.

好吧, 一开始可能会有些小bug, 大不了重来一次. 我重新开始转换, 进度条又停在了79%. 好吧, 可能我录制得太长, 数据卡住了, 我重新录制了很短的一句话, 大概就5秒钟, 并且换了个声音模型, 开始转换. 进度条这次走很快, 然后卡在了79%.

这就奇怪了, 难道是我的DAW网络连接的问题? 我重启DAW, 再次录制一小段话, 载入一个Model, 进行转换. 问题依旧, 卡在了79%. 是因为打完折后卖79美元所以给我来这么一出吗? 但我也只是试用, 并没有买啊.

好在由于运算失败, 倒是一分token都没收我的, 还是满满的9000个token(如果购买买断版将不会限制转换次数).

SoundID再次因为技术的不成熟损失了我这个潜在的用户. 接下来几天因为忙着录音和后期, 我顾不上再测试这款插件. 时间很快到了1月8日, 我收到了一封来自SoundID的邮件:

You Trial has ended, 你的试用期结束. 到今天, 1月9日, 我又收到一封邮件, 提示我的Token用完了.

害, 真是催得紧啊.

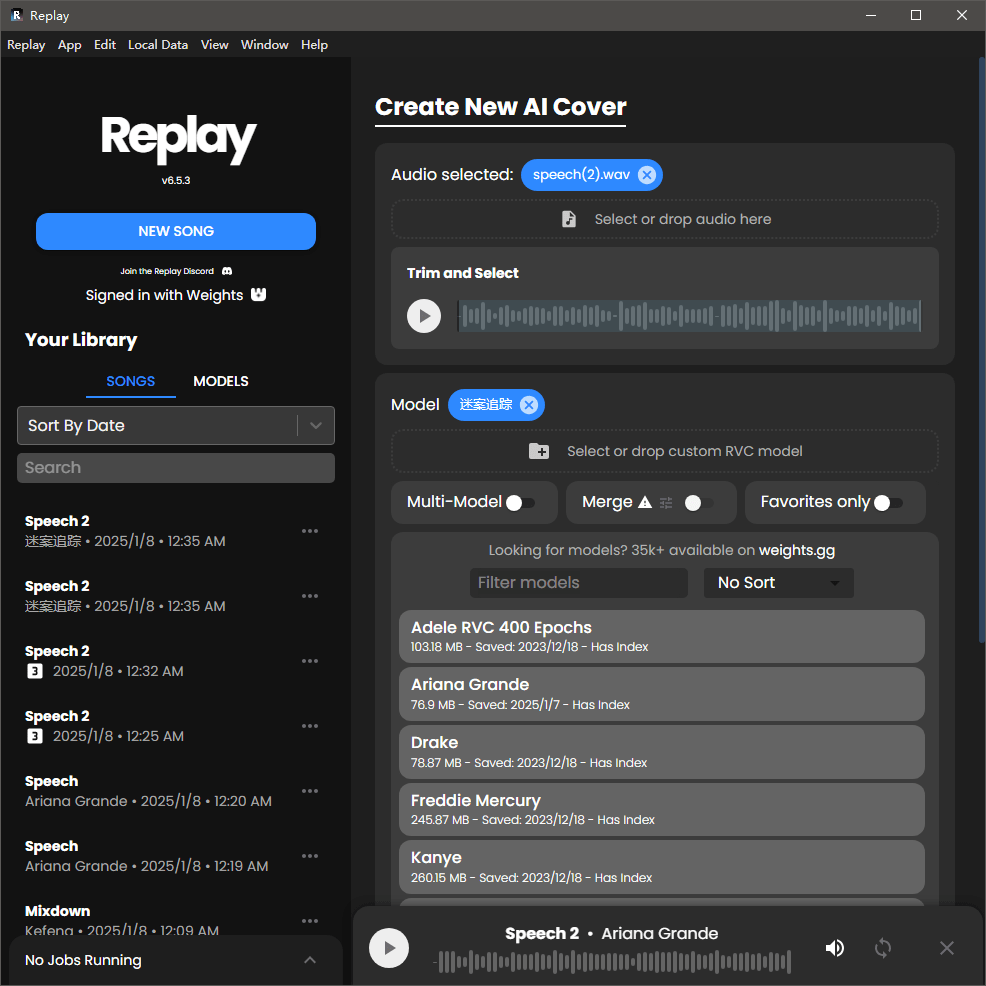

抛开我压根就没成功试用VoiceAI不说, 就我从油管多个评测视频中所观察得知, 这款VoiceAI其实也并没有太多技术含量, 它使用的依然是目前市场上最主流的神经元套模的方式. 除了这些大公司误以为发现了什么百宝箱想大捞一笔的之外, 市场上其实已经有了很多免费且优质稳定的应用. 我为什么对SoundID的VoiceAI不屑一顾, 是因为前文提到过, 我很早就发现了Replay这个非常棒的免费应用.

它没有任何的转换限制, 还可以到开源市场去下载安装model也就是声音建模, 不仅如此, 我还可以从我的录音中选择不同的人声, 去创建模型.

它的使用方法, 也和当前AI人声的制作方式一样, SoundID VoiceAI也只不过是设计了一个插件形式, 但运行方式依然是相同的. 即, 我们录制一段人声, 可以是说话, 也可以是带有音高的演唱, 混出为音频文件, 然后载入Replay, 同时再选择一个model作为替换声音, 接着按下Create Song即可.

AI会捕捉这段音频中的关键发音方式, 频率和振幅, 然后将你选中的model中的关键声纹套用上去, 瞬间将你的音色全部改变, 但发音方式还是你自己的, 这点和国内市面上流通的AI识别文本, 捕捉大致情绪, 再套用声音模型的方式有所不同, 这种属于模仿型AI, 还较为初级. 但其在音乐上的作用不容小觑.

以上就是我的声音, 和我下载的Ariana Grande的声音做的替换, 男声转换为女声时, 我们需要提高几个pitch, 不然超过女声的自然音域, 女声就会出现失真, 反过来也一样, 女声替换为男声模型, 就需要压低几个pitch.

你可能会发现替换为AI模型后, 还是会出现少量的失真. 这终究不是智慧型替换, 而只是声纹上的套用. 但对于我来说, 掌握了AI人声技术的最大好处, 就是应用于音乐中. 我可以创建一个非常棒的伴唱群, 我只需要演唱一段范唱, 然后交给伴唱们去完成更适合的音域. 我还可以再次利用Melodyne, 利用它们的唱词, 仅仅修改一部分基于和声的音高, 从而达到和声伴唱的效果.

以上我演唱了一段Phil Collins的In the air, 然后请来Adele和Ariana为我伴唱, 尽管听起来不是特别像她们的声音(毕竟是采用的我的发音方式), 但用来做伴唱的效果绝对好过再次使用我的声音. 而且, 未来的应用中我还可以不断的采集各种声音, 将它们用于背景声音的用途.

以上则是一段我用我的声音模仿群演的效果, 再套用多个模型, 最后拼凑而成. 由于我并没有特意模仿不同角色的说话方式, 所以语言听起来没有特别夸张, 但这已经足够显示AI人声的广泛应用性了.

其实, 这篇文章与其说是试用SoundID VoiceAI, 倒反而是对Replay的称赞. Replay有着更开放的调整, 让我在应用时也逐步理解了AI人声的使用方式, 它还可以由用户自行创建模型, 相当于可以制作一个逐步庞大的人声音色库, 对于音乐创作和后期来说有着巨大的帮助. 关键它还是免费的.

请问SoundID, 阁下如何应对?